超越自注意力:用于医学图像分割的可变形大核注意力

原文:《Beyond Self-Attention: Deformable Large Kernel Attention for Medical Image Segmentation》

本文贡献

- 为了解决上述挑战,我们提出了 DeformableLKA 模块 (❶) 形式的解决方案,它作为我们网络设计中的基本构建块。该模块被明确设计为有效处理上下文信息,同时保留局部特征。

- 我们的架构中两个方面之间的平衡增强了其实现精确语义分割的能力。值得注意的是,我们的模型引入了基于数据的感受野的动态适应,这与传统卷积运算中的传统固定滤波器掩模不同。这种自适应方法使我们能够克服与静态方法相关的固有限制。这种创新方法扩展到 D-LKA 网络架构 (❷) 的 2D 和 3D 版本的开发。对于 3D 模型,D-LKA 机制经过定制以适应 3D 环境,从而实现不同体积切片之间的无缝信息交换。

- (❸) 最后,我们的贡献进一步强调了它的计算效率。我们通过完全依赖 D-LKA 概念的设计实现了这一目标,从而在各种细分基准上取得了卓越的性能,从而使我们的方法成为一种新的 SOTA 方法。

主要方法

在本节中,我们首先概述该方法。首先,我们回顾一下由 Guo 等人 [23] 提出的大核注意力(LKA)的概念。然后,我们介绍了我们对可变形 LKA 模块的创新探索。在此基础上,我们引入了用于分割任务的 2D 和 3D 网络架构。

大核注意力(LKA)

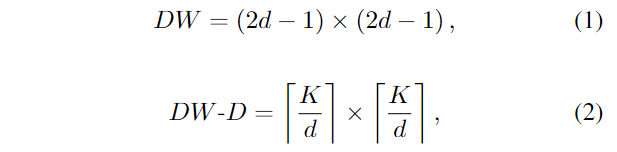

大卷积核提供与自注意力机制类似的感受野。通过使用深度卷积、深度扩张卷积和

内核大小为

内核大小为

FLOPs

的数量随着输入图像的大小线性增长。参数数量随着通道数量和内核大小呈二次方增加。然而,由于两者通常都很小,因此它们不是限制因素。

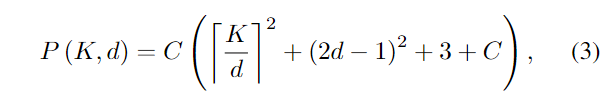

为使核大小

FLOPs

的数量随着输入图像的大小线性增长。参数数量随着通道数量和内核大小呈二次方增加。然而,由于两者通常都很小,因此它们不是限制因素。

为使核大小  例如,当内核大小为

例如,当内核大小为  内核大小为

内核大小为

可变形大核注意力

利用大核(Large

kernel)进行医学图像分割的概念通过加入可变形卷积(Deformable

Convolutions)得到了扩展

[20]。可变形卷积可以通过整数偏移调整采样网格以实现自由变形。附加的卷积层从特征图中学习变形,从而创建偏移场。根据特征本身学习变形,得到自适应卷积核。这种灵活的内核形状可以改善病变或器官变形的表示,从而增强物体边界的清晰度。负责计算偏移量的卷积层遵循其相应卷积层的内核大小和膨胀。双线性插值用于计算图像网格上未找到的偏移的像素值。

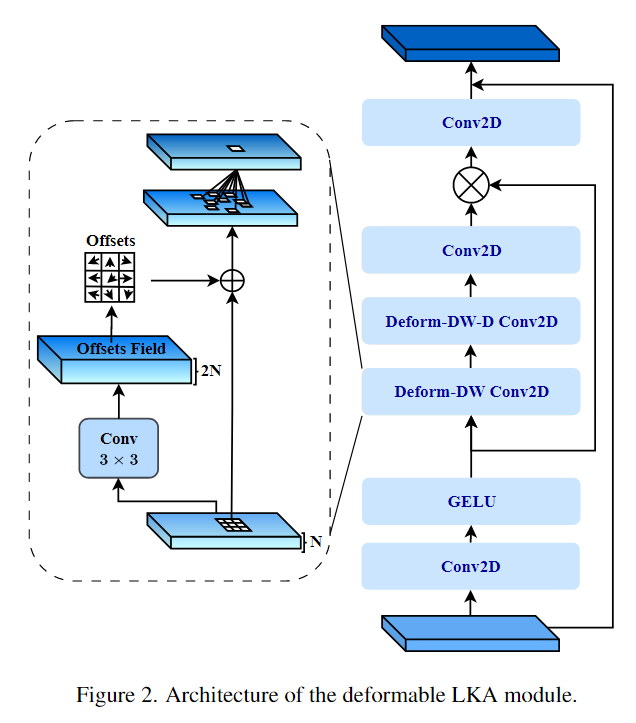

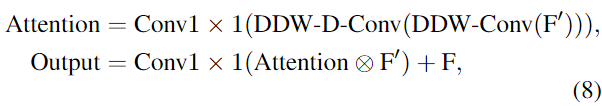

如图2所示,D-LKA模块可以表述为:

如图2所示,D-LKA模块可以表述为:  其中,输入特征用

其中,输入特征用

2D D-LKA Net

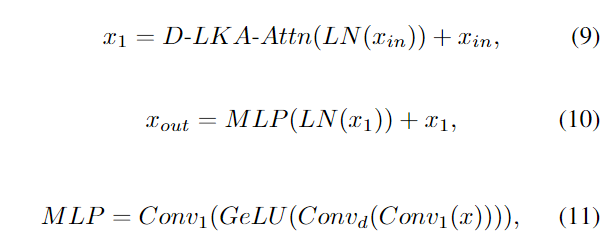

2D D-LKA 块的结构包括 LayerNorm、可变形 LKA 和多层感知器

(MLP)。残差连接的集成确保了有效的特征传播,甚至跨更深的层。这种排列可以在数学上表示为:

输入特征

输入特征

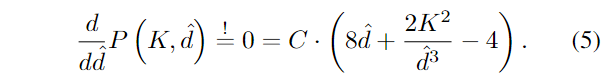

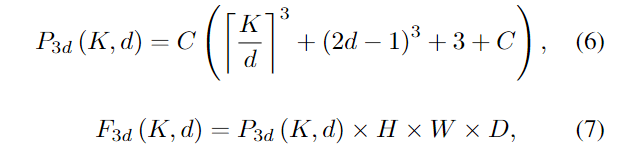

3D D-LKA Net

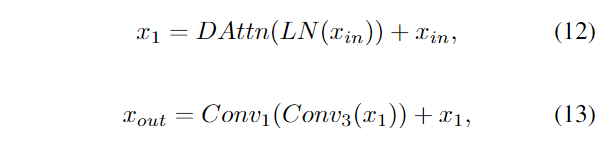

图 1 所示的 3D

网络架构采用编码器-解码器设计进行分层构建。最初,补丁嵌入层将输入图像尺寸从

输入特征

输入特征