基于双分支双注意机制网络的高光谱图像分类

原文:《Classification of Hyperspectral Image Based on Double-Branch Dual-Attention Mechanism Network》

摘要

近年来,研究人员越来越关注使用深度学习方法进行高光谱图像 (HSI) 分类。 为了提高准确性并减少训练样本,我们在本文中提出了一种用于 HSI 分类的双分支双注意力机制网络 (DBDA)。 DBDA 中设计了两个分支来捕获 HSI 中包含的大量光谱和空间特征。 此外,通道注意力块和空间注意力块分别应用于这两个分支,这使得 DBDA 能够细化和优化提取的特征图。 在四个高光谱数据集上进行的一系列实验表明,所提出的框架具有优于最先进算法的性能,尤其是在训练样本明显缺乏的情况下。

主要贡献

在本文中,受最先进的 DBMA 算法和自适应自注意机制双重注意网络(DANet)[44] 的启发,我们设计了用于 HSI 分类的双分支双重注意机制网络(DBDA) 。所提出的框架包含两个分支,分别称为光谱分支和空间分支,分别捕获光谱和空间特征。 采用通道注意机制和空间注意机制来细化特征图。 通过连接两个分支的输出,我们获得了融合的光谱空间特征。 最后,使用 softmax 函数确定分类结果。 本文的三个重要贡献可列举如下:

- 基于 DenseNet 和 3D-CNN,我们提出了一个端到端框架双分支双注意力机制网络 (DBDA)。 所提出框架的光谱分支和空间分支可以分别利用特征而无需任何特征工程。

- 在光谱和空间维度上引入了一种灵活且自适应的自注意力机制。通道注意块主要关注信息丰富的光谱波段,空间注意块主要关注信息丰富的像素点。

- DBDA 在训练数据有限的四个数据集中获得了最先进的分类精度。 此外,我们提出的网络的时间消耗少于两个比较的深度学习算法。

注意力机制

3D-CNN 的一个缺点是所有空间像素和光谱带在空间和光谱域中具有等效的权重。 显然,不同的光谱波段和空间像素对提取特征的贡献不同。 注意力机制是处理这个问题的强大技术。 受人类视觉感知过程 [46] 的启发,注意力机制旨在更多地关注信息区域,而较少考虑非必要区域。 注意机制已被用于图像分类[47],后来被证明在其他领域表现出色,包括图像描述[48]、文本到图像合成[49]和场景分割[44]等。在DANet[44]中 ,可以采用通道注意块和空间注意块来增加引人注目的通道和像素的权重。 下面将对这两个块进行详细介绍。

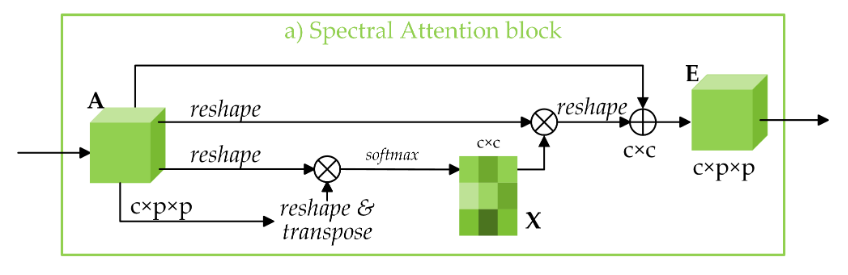

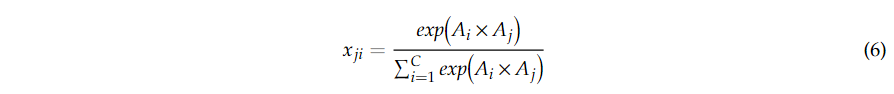

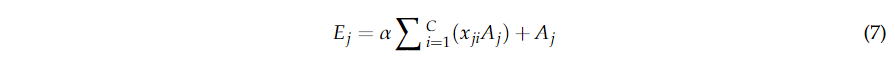

光谱注意块

如图 4a 所示,通道注意力图 其中

其中 其中

其中

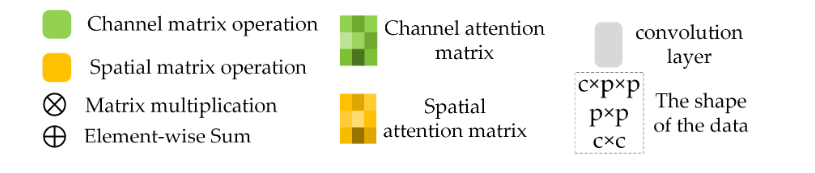

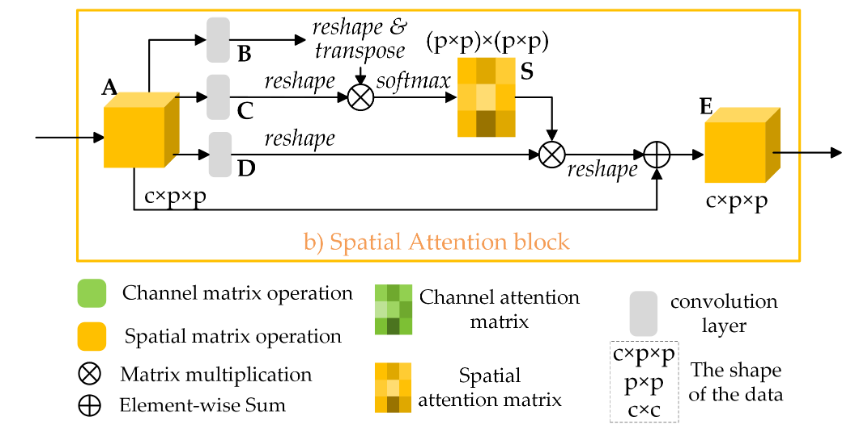

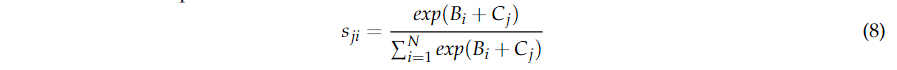

空间注意块

如图 4b 所示,给定输入特征图 其中

其中 其中初始值为零的

其中初始值为零的

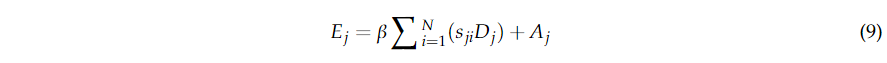

本文方法

DBDA 框架的过程包含三个步骤:数据集生成、训练和验证以及预测。 图 5

说明了我们方法的整个框架。  一个 HSI 数据集

一个 HSI 数据集 其中

其中

DBDA 网络的框架

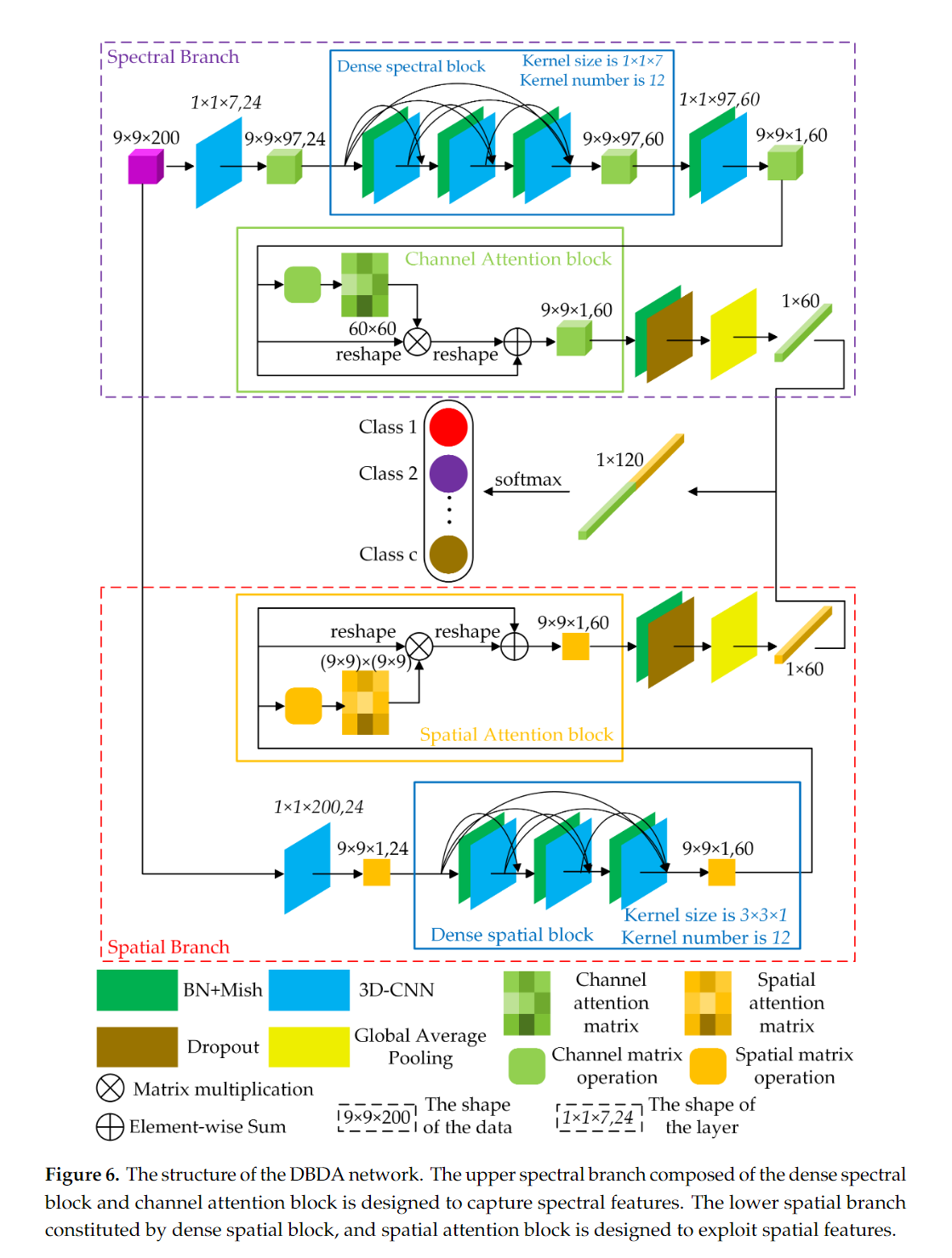

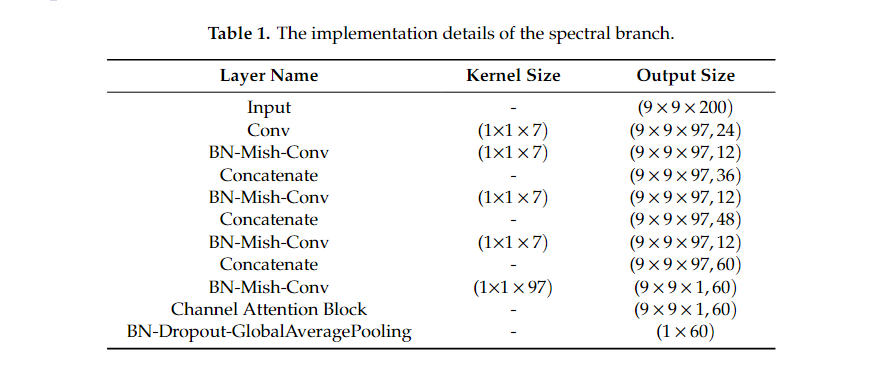

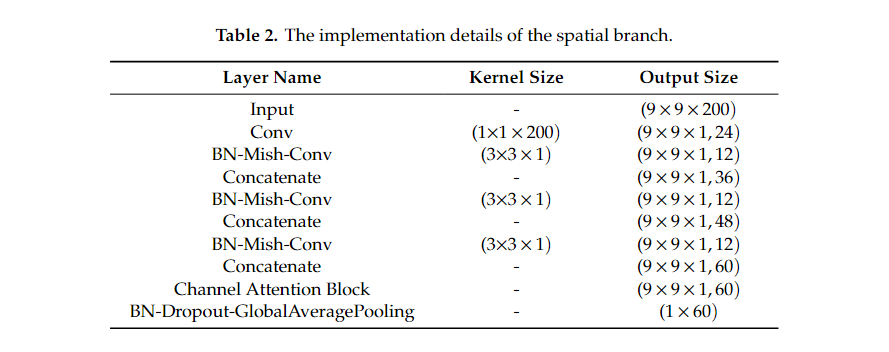

DBDA 网络的整体结构如图 6

所示。为方便起见,我们将顶部分支称为光谱分支,将底部分支命名为空间分支。输入分别送入光谱分支和空间分支,得到光谱特征图和空间特征图。

然后采用光谱和空间特征图之间的融合操作得到分类结果。 以下部分以Indian

Pines

(IP)数据集为例,介绍光谱分支、空间分支和光谱空间融合操作;patch大小指定为

具有通道注意块的频谱分支

首先,使用

具有空间注意块的空间分支

同时,将

HSI 分类的光谱和空间融合

利用光谱分支和空间分支,得到多个光谱特征图和空间特征图。然后,我们在两个特征之间进行连接以进行分类。之所以应用级联运算而不是加法运算,是因为光谱和空间特征处于不相关的域中,级联运算可以保持他们的独立性,而加法运算会将它们混合在一起。最后通过全连接层和softmax激活函数得到分类结果。

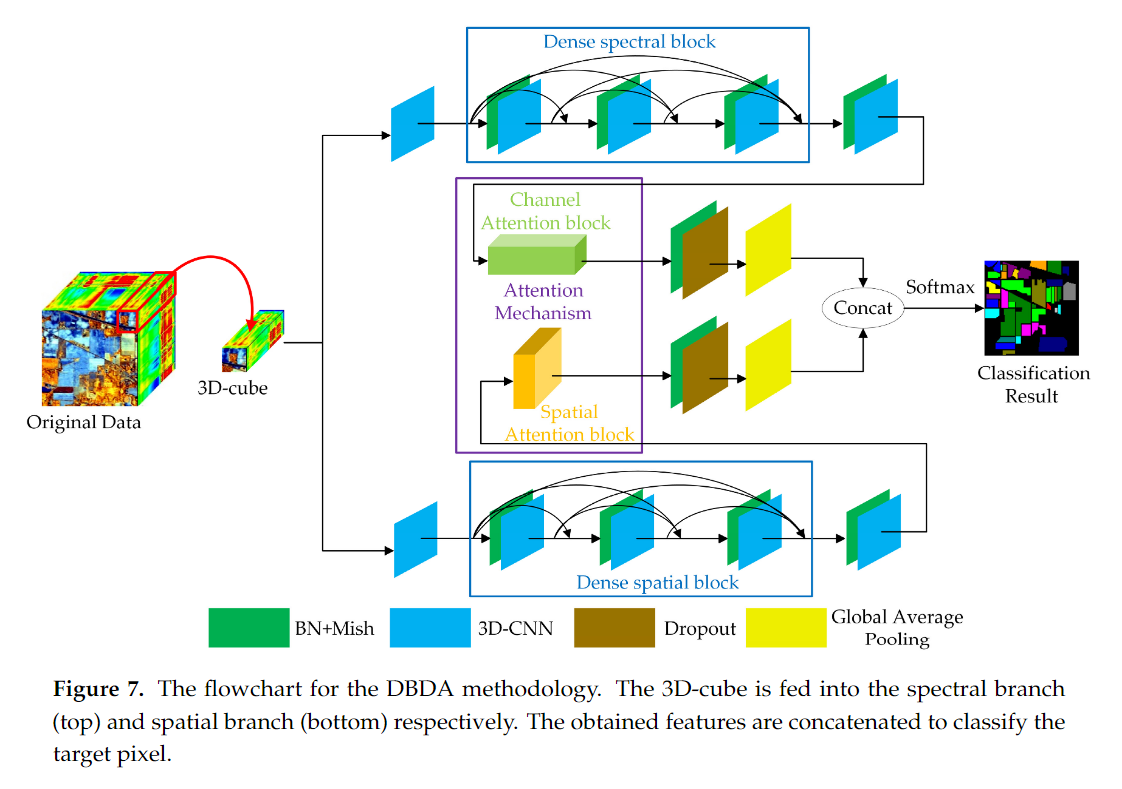

对于其他数据集,网络实现是相同的,唯一的区别是光谱波段的数量。DBDA的整个方法流程图如图7所示。

防止过拟合的措施

大量的训练参数和有限的训练样本导致网络容易出现过拟合。因此,我们采取了一些措施来防止过拟合。

一个强大而适当的激活函数

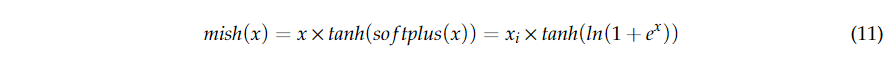

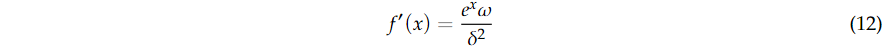

激活函数将非线性的概念引入神经网络。合适的激活函数可以加快网络反向传播和收敛的速度。我们采用的激活函数是自正则化非单调激活函数Mish[50],而不是传统的ReLU(x)

= max(0, x)[51]。Mish的公式是:  其中

其中

其中 ReLU

是一个分段线性函数,可以剔除所有负输入。因此,如果输入是非正的,那么神经元将”死亡“并且不能再被激活,即使负输入可能包含有用的信息。相反,Mish

将负输入保留为负输出,从而更好地交换输入信息和网络稀疏性。

ReLU

是一个分段线性函数,可以剔除所有负输入。因此,如果输入是非正的,那么神经元将”死亡“并且不能再被激活,即使负输入可能包含有用的信息。相反,Mish

将负输入保留为负输出,从而更好地交换输入信息和网络稀疏性。

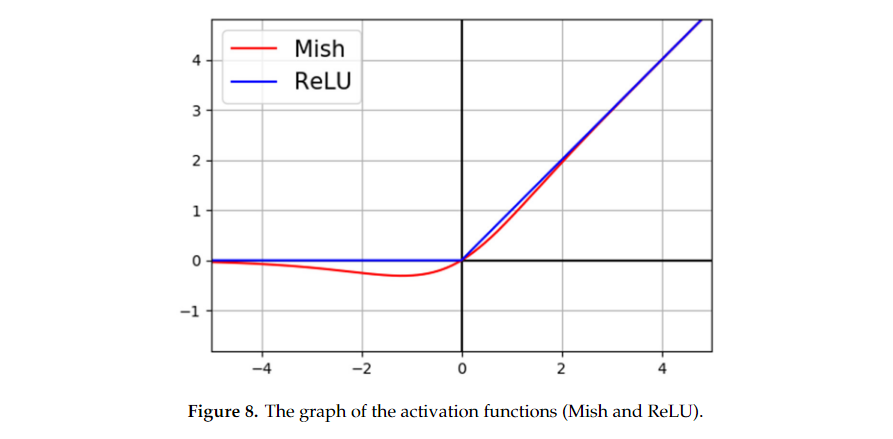

Dropout层,早停策略和动态学习率调整

在最后一个 BN 层和空间分支和光谱分支中的全局平均池化层之间分别采用了

dropout 层 [52]。Dropout

是一种简单但有效的方法,通过在训练阶段丢弃给定百分比 其中

其中