用于高光谱图像分类的光谱空间特征标记化Transformer

原文:《Spectral-Spatial Feature Tokenization Transformer for Hyperspectral Image Classification》

摘要

在高光谱图像 (HSI) 分类中,每个像素样本都分配给一个土地覆盖类别。 近年来,基于卷积神经网络(CNN)的 HSI 分类方法由于其卓越的特征表示能力而大大提高了性能。 然而,这些方法获取深层语义特征的能力有限,并且随着层数的增加,计算成本显着上升。 Transformer框架可以很好地表示高级语义特征。 在本文中,提出了一种光谱空间特征标记化Transformer(SSFTT)方法来捕获光谱空间特征和高级语义特征。 首先,构建光谱空间特征提取模块来提取低级特征。 该模块由3维卷积层和2维卷积层组成,用于提取浅层光谱和空间特征。 其次,引入高斯加权特征Transformer进行特征转换。 第三,将变换后的特征输入到Transformer编码器模块中进行特征表示和学习。 最后,使用线性层来识别第一个可学习的标记以获得样本标签。 使用三个标准数据集,实验分析证实,计算时间少于其他深度学习方法,并且分类性能优于当前几种最先进的方法。 为了重现性,这项工作的代码可以在 https://github.com/zgr6010/HSI_SSFTT 上找到。

本文思路

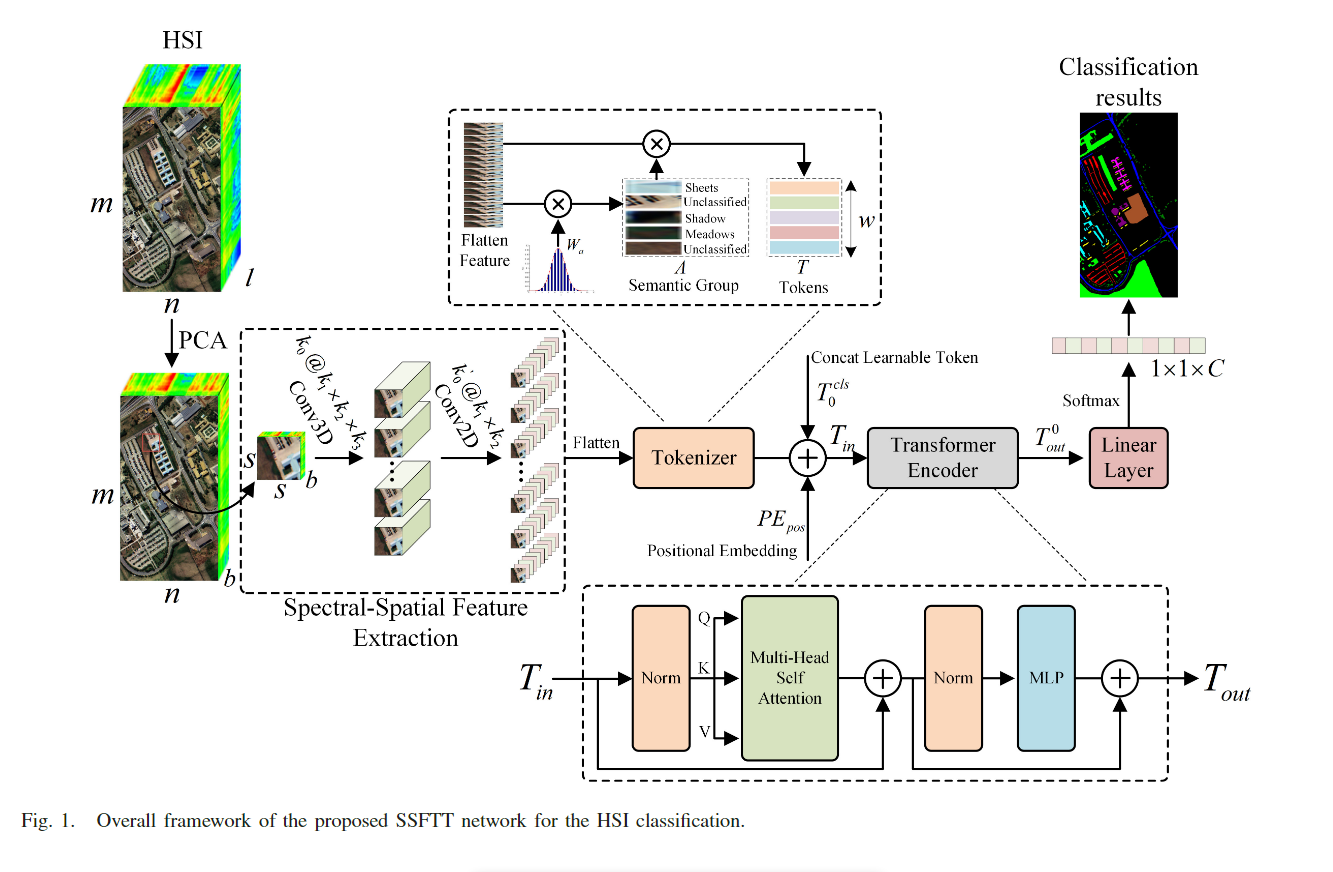

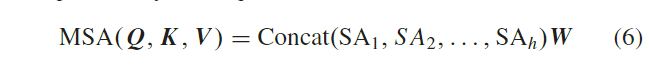

大多数方法都是基于 CNN 主干及其变体。虽然这些方法有效提高了HSI分类性能,但由于训练样本有限和网络层数增加造成的分类性能下降难以克服。 它们还具有过多的功能冗余。 最近,一种名为视觉Transformer(ViT)的新模型在图像处理领域表现良好。已经做了一些工作来将Transformer模型应用于HSI分类。然而,大部分方法都是基于光谱信息处理的改进的Transformer方法。尽管Transformer在捕获光谱特征方面表现突出,但它在捕获局部语义特征方面失去了能力,并且没有充分利用图像空间信息。 原始的Transformer[60]是基于自注意力(SA)机制的应用于自然语言处理(NLP)的模型。 模型的输入是一系列标记。 多头注意力用于绘制输入标记序列中的全局相关性。 因此,为了利用Transformer获取局部空间语义信息的能力并对相邻序列之间的关系进行建模,提出了一种用于 HSI 分类的谱空间特征标记化Transformer(SSFTT)模型。 首先,在该模型中,使用 3-D 卷积层和 2-D 卷积层来提取浅层光谱空间特征。 这有效地减少了层数增加带来的特征冗余和不准确。 其次,展平的特征由高斯加权标记器进行标记。然后,生成的令牌用作 TE 模块的输入。 最后,采用基于 softmax 的线性分类器来确定每个像素的标签。

本文贡献

- 我们的 SSTFF 网络中提出了一种简单高效的分层 CNN 模块,用于提取浅层空间光谱特征。 它仅由1个 3D 卷积层和1个 2D 卷积层组成。 然后,该模块与 Transformer 结构相结合,开发出一种新的轻量级网络来替代单个 CNN 结构,以降低计算成本。

- 提出了高斯分布加权标记化模块,将浅层空间谱特征转换为标记化语义特征。 其作用是使token所表达的深层语义特征更加符合样本的分布特征,从而使样本更加可分。

- CNN网络与Transformer结构从浅到深的系统结合,可以充分利用HSI中的光谱空间信息,简洁高效地表达HSI的低中深语义特征,从而显着提高分类精度。

本文方法

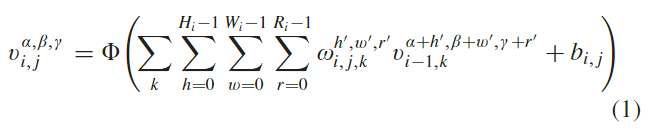

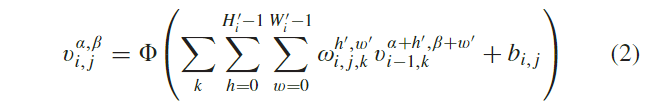

光谱空间特征提取

给出原始 HSI 数据 其中

其中 其中

其中

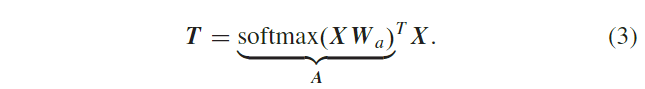

高斯加权特征标记器

两层卷积运算提取的特征携带了光谱和空间信息,但不能充分描述地物特征。因此,特征图被进一步定义为语义标记,可以表示和处理

HSI 特征类别的高级语义概念。对于这部分,输入展平特征图被定义为 这里,

这里,

Transformer编码器模块

如图 1 所示,第 II-B 节中生成的语义标记作为 TE

模块的输入,以学习高级语义特征之间的关系。该模块主要由三个子部分组成。

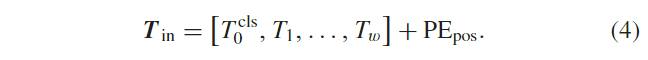

作为第一子部分,使用位置嵌入来标记每个语义标记的位置信息。每个标记由 第二个也是重要的子部分是

TE。该块旨在对语义标记之间的深层关系进行建模。它包含一个多头 SA (MSA) 块

[见图 3(a)]、一个 MLP 层和两个归一化层 (LN)。在 MSA 块和 MLP

层之前设计了残差跳跃连接。

第二个也是重要的子部分是

TE。该块旨在对语义标记之间的深层关系进行建模。它包含一个多头 SA (MSA) 块

[见图 3(a)]、一个 MLP 层和两个归一化层 (LN)。在 MSA 块和 MLP

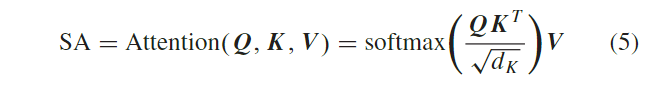

层之前设计了残差跳跃连接。  由于其核心 MSA

块,Transformer结构表现良好。该块中使用 SA

机制[见图3(b)]有效地捕获了特征序列之间的相关性。为了学习多种含义,预先定义三个可学习的权重矩阵

由于其核心 MSA

块,Transformer结构表现良好。该块中使用 SA

机制[见图3(b)]有效地捕获了特征序列之间的相关性。为了学习多种含义,预先定义三个可学习的权重矩阵 其中

其中 其中

其中

实施

与骨干CNN相比,SSFTT 减少了网络层数。此外,它可以通过引入标记器和 TE

在图像补丁的语义级别上进行建模。这里选择大小为 经过PCA降维和块提取后,每个块的大小为

经过PCA降维和块提取后,每个块的大小为