利用所有未标记数据促进半监督学习

原文:《Boosting Semi-Supervised Learning by Exploiting All Unlabeled Data》

摘要

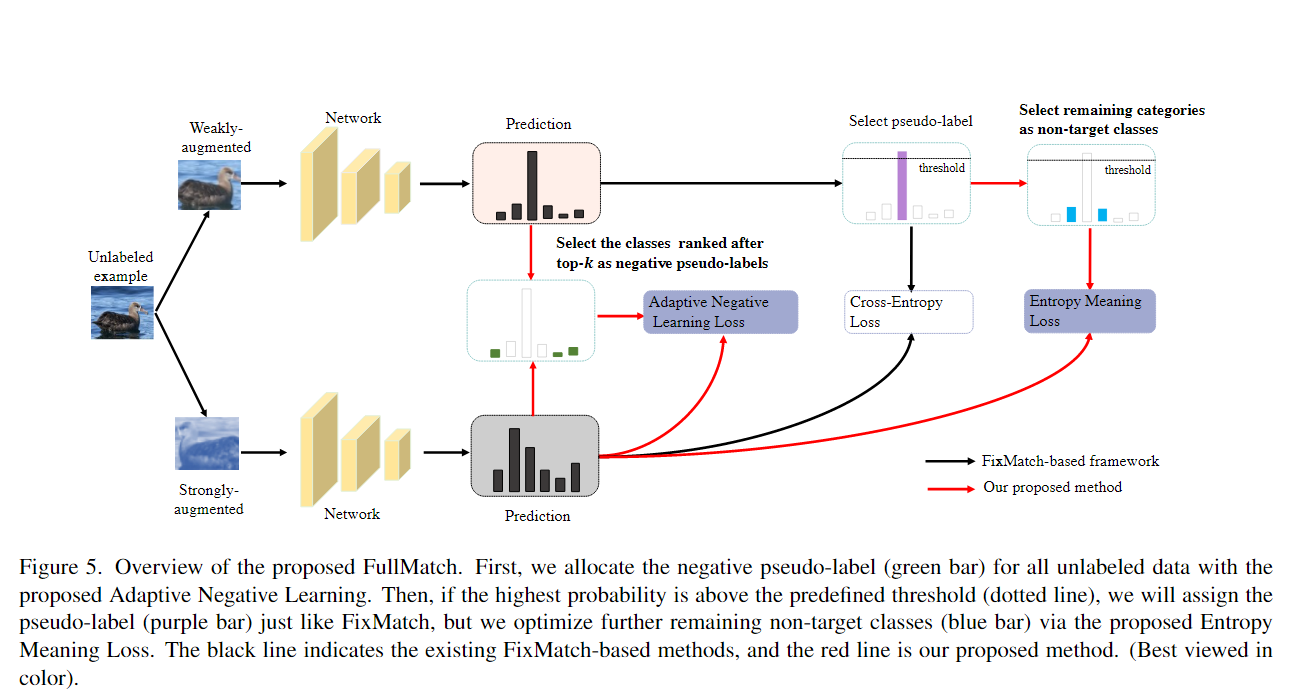

半监督学习(SSL)由于其在减轻对大型标记数据集的依赖方面的巨大潜力而引起了极大的关注。最新的方法(例如 FixMatch)结合使用一致性正则化和伪标签来取得显着的成功。然而,这些方法都浪费了复杂的样本,因为所有伪标签都必须通过高阈值来选择以滤除噪声标签。因此,预测不明确的样本不会对训练阶段做出贡献。为了更好地利用所有未标记的样本,我们提出了两种新技术:熵意义损失(EML)和自适应负学习(ANL)。EML将非目标类的预测分布纳入优化目标,以避免与目标类竞争,从而生成更多高置信度的预测来选择伪标签。ANL 为所有未标记的数据引入了额外的负伪标签,以利用低置信度样本。它通过动态评估模型的 top-k 性能来自适应地分配该标签。EML和ANL没有引入任何额外的参数和超参数。我们将这些技术与 FixMatch 集成,并开发了一个简单但功能强大的框架,称为 FullMatch。对几种常见 SSL 基准(CIFAR10/100、SVHN、STL-10 和 ImageNet)的大量实验表明,FullMatch 大幅超过 FixMatch。与 FlexMatch(一种基于 FixMatch 的高级框架)集成,我们实现了最先进的性能。源代码位于 https://github.com/megvii-research/FullMatch。

本文思路

基于 FixMatch

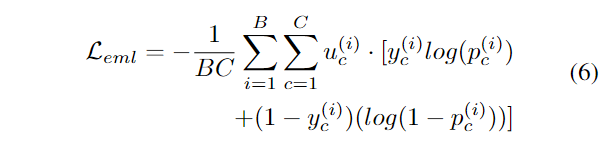

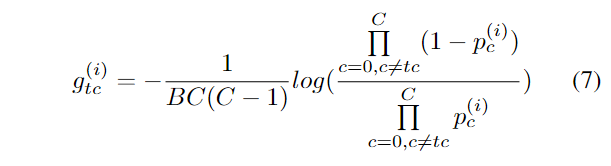

的方法有一个显着的缺点,即它们依赖于极高的阈值来生成准确的伪标签,这导致忽略大量具有模糊预测的未标记示例,尤其是在早期和中期训练阶段。一种直观的解决方案是为潜在示例分配伪标签(即最大置信度接近预定义阈值)。我们认为部分类别之间的竞争导致无法产生高置信度的预测,而在使用伪标签训练示例时,FixMatch(即交叉熵)的无监督损失仅关注目标类别。因此,我们提出了一种新的方案来增强目标类别的置信度,即熵意义损失(EML)。对于带有伪标签的示例,EML

对所有非目标类(即指定不存在特定标签的类)施加额外的监督,以使它们的预测接近均匀分布,从而防止与目标类发生任何类竞争。由于

EML

试图产生更多的低熵预测来选择更多带有伪标签的示例,而不是调整阈值,因此它也可以应用于任何动态阈值方法。

尽管如此,仍然不可能通过阈值策略生成伪标签来利用所有未标记的数据。这促使我们进一步考虑如何利用没有伪标签的低置信度未标记示例(即最大置信度远离预定义阈值)。直观上,预测可能会在

top 类别之间混淆,但可以确信输入不属于排在这些类别之后的类别。

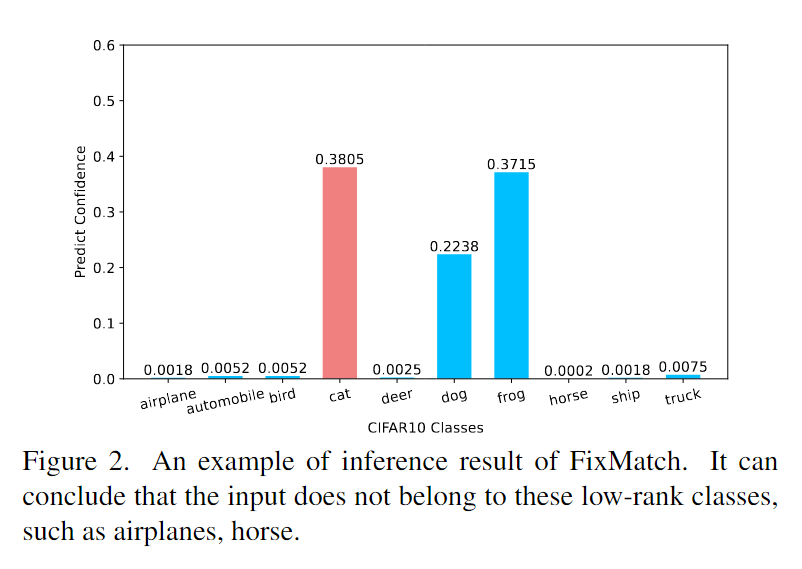

图2展示了 FixMatch 的推理结果。真实类别是“猫”,FixMatch

被几个 top

类别(例如“狗”、“青蛙”)混淆并做出低置信度预测,但它显示出对某些低等级类别(例如“飞机”、“马”)不是真实类别的高度置信度,因此我们可以安全地为这些类别分配负伪标签。基于这一见解,我们提出了一种名为自适应负学习(ANL)的新方法。具体来说,ANL

首先根据预测一致性自适应计算

图2展示了 FixMatch 的推理结果。真实类别是“猫”,FixMatch

被几个 top

类别(例如“狗”、“青蛙”)混淆并做出低置信度预测,但它显示出对某些低等级类别(例如“飞机”、“马”)不是真实类别的高度置信度,因此我们可以安全地为这些类别分配负伪标签。基于这一见解,我们提出了一种名为自适应负学习(ANL)的新方法。具体来说,ANL

首先根据预测一致性自适应计算

本文贡献

- 在使用伪标签训练样本时,我们引入了一种额外的监督,即熵意义损失(EML),它强制非目标类的均匀分布,以避免它们与目标类竞争,从而产生更多的高置信度预测。

- 我们提出了自适应负学习(ANL),这是一种动态负伪标签分配方案,它以非常有限的额外计算开销的为所有未标记数据(包括低置信度样本)设置负伪标签。

- 我们设计了一个简单而有效的框架,名为 FullMatch,通过简单地将 FixMatch 与所提出的 EML 和 ANL 集成,它利用所有未标记的数据,从而在五个基准上取得显着的收益。

本文方法

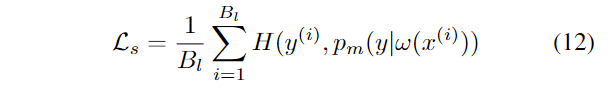

熵意义损失(EML)

我们提出熵意义损失来分配更多带有伪标签的样本。当前大多数工作都集中在动态调整阈值(例如

FlexMatch、Dash)。与它们不同的是,我们的目标是加强模型本身的表示能力,以产生更多远离决策边界的预测(即高置信度预测),这意味着它与那些动态阈值工作正交。

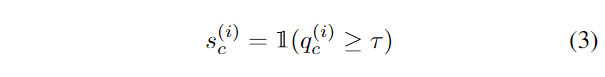

我们假设 其中

其中 我们假设

我们假设

其中 请注意,

请注意, EML

和无监督损失

EML

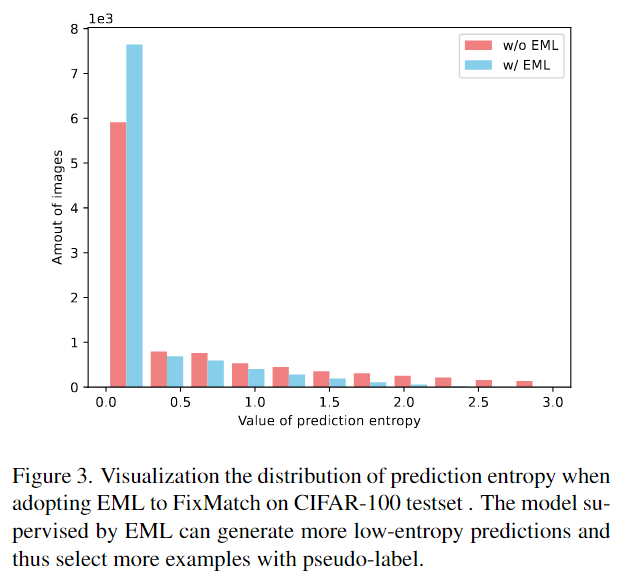

和无监督损失 为了直观地说明 EML 的有效性,图 3 比较了引入 EML

和不引入 EML 的情况下 CIFAR100 测试集上的预测熵分布。 总图像为 10000

张。显然,引入 EML 后,低熵预测量(例如预测熵值小于 0.25)将增加约

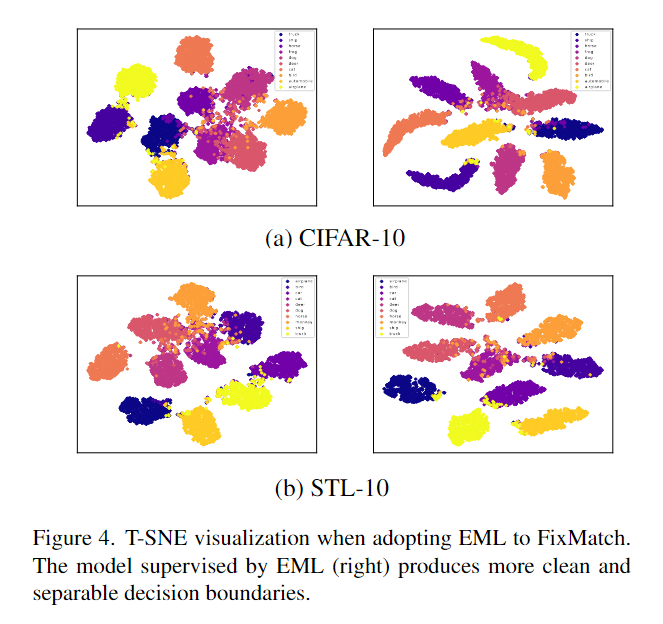

18%(78% vs 60%)。 我们通过在 CIFAR-10 和 STL-10 [5] 上使用 t-SNE [28]

进一步证明了 EML 的有效性。 图 4 表明 EML

可以产生更清晰、可分离的边界,从而给出更高置信度的预测。

为了直观地说明 EML 的有效性,图 3 比较了引入 EML

和不引入 EML 的情况下 CIFAR100 测试集上的预测熵分布。 总图像为 10000

张。显然,引入 EML 后,低熵预测量(例如预测熵值小于 0.25)将增加约

18%(78% vs 60%)。 我们通过在 CIFAR-10 和 STL-10 [5] 上使用 t-SNE [28]

进一步证明了 EML 的有效性。 图 4 表明 EML

可以产生更清晰、可分离的边界,从而给出更高置信度的预测。

自适应负学习(ANL)(动态负伪标签)

由于在复杂的场景下很容易产生模糊的预测(例如,最大置信度只有0.3,而阈值是0.95),这些例子很难被分配伪标签(通过阈值过滤或不正确的预测),因此对模型优化没有贡献。为了解决这个问题,我们分配了一个噪声较小的附加标签来利用这些示例。

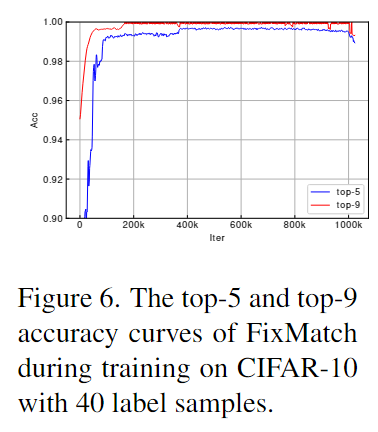

图 6 展示了当标记数据量仅为 40 时 FixMatch 在 CIFAR-10

上的 top-

图 6 展示了当标记数据量仅为 40 时 FixMatch 在 CIFAR-10

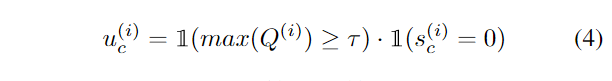

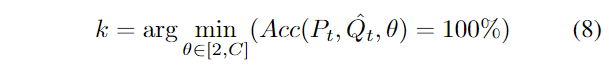

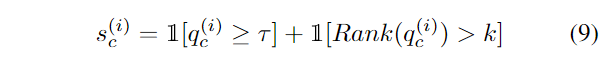

上的 top- 其中

其中  其中

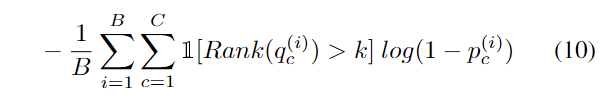

其中  请注意,使用 ANL

的成本几乎是免费的。它不引入任何额外的前向传播过程来评估性能,也没有引入任何新的超参数。与

请注意,使用 ANL

的成本几乎是免费的。它不引入任何额外的前向传播过程来评估性能,也没有引入任何新的超参数。与

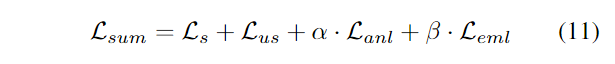

FullMatch

通过将熵意义损失(EML)和自适应负学习(ANL)集成到 FixMatch

中,我们提出了一种名为 FullMatch 的高级 SSL 算法。由于 ANL

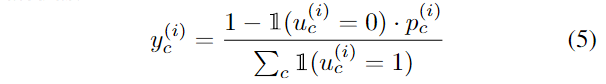

可以为所有未标记的数据分配负伪标签,因此它鼓励我们在计算  如图 5

所示,我们首先计算

如图 5

所示,我们首先计算  为了简单起见,我们将

为了简单起见,我们将 其中

其中