HyperViTGAN:基于Transformer半监督生成对抗网络的高光谱图像分类

原文:《HyperViTGAN: Semi-supervised Generative Adversarial Network with Transformer for Hyperspectral Image Classification》

摘要

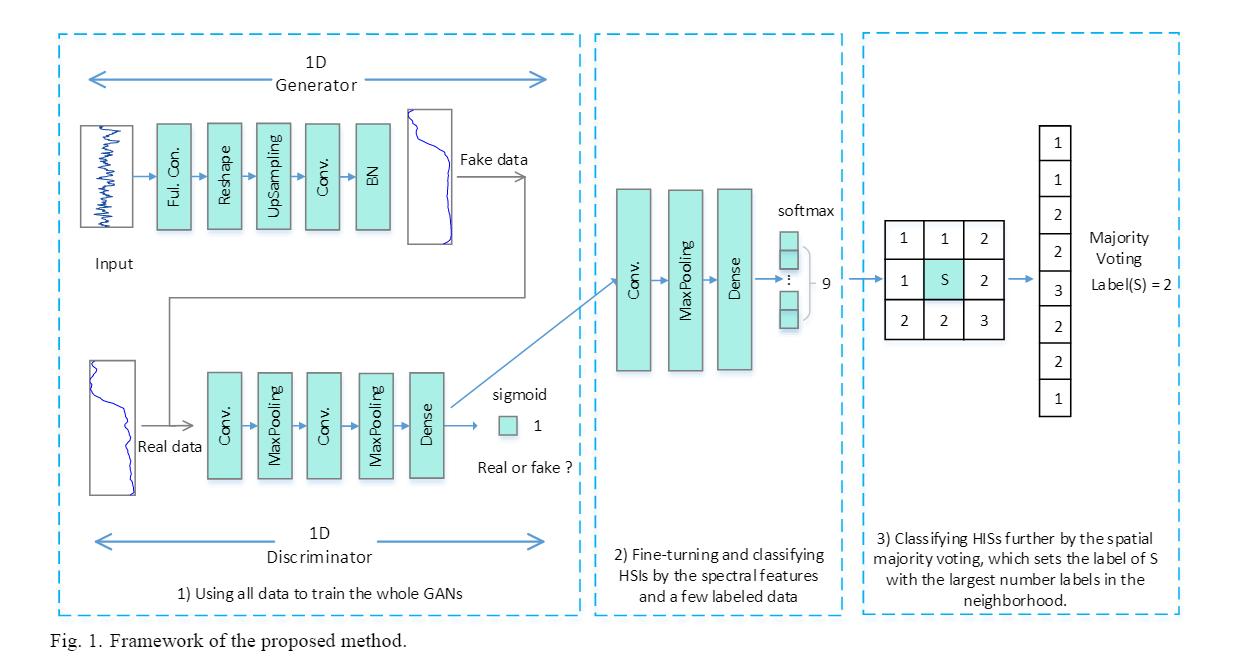

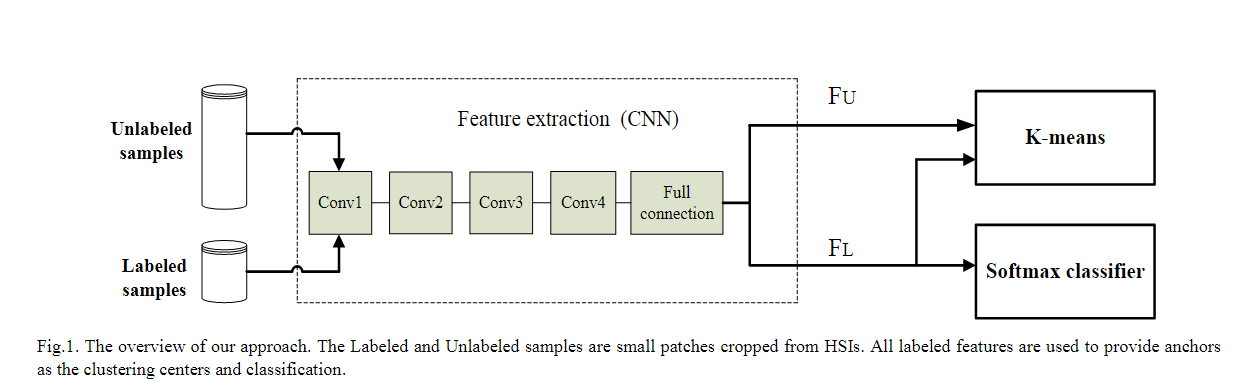

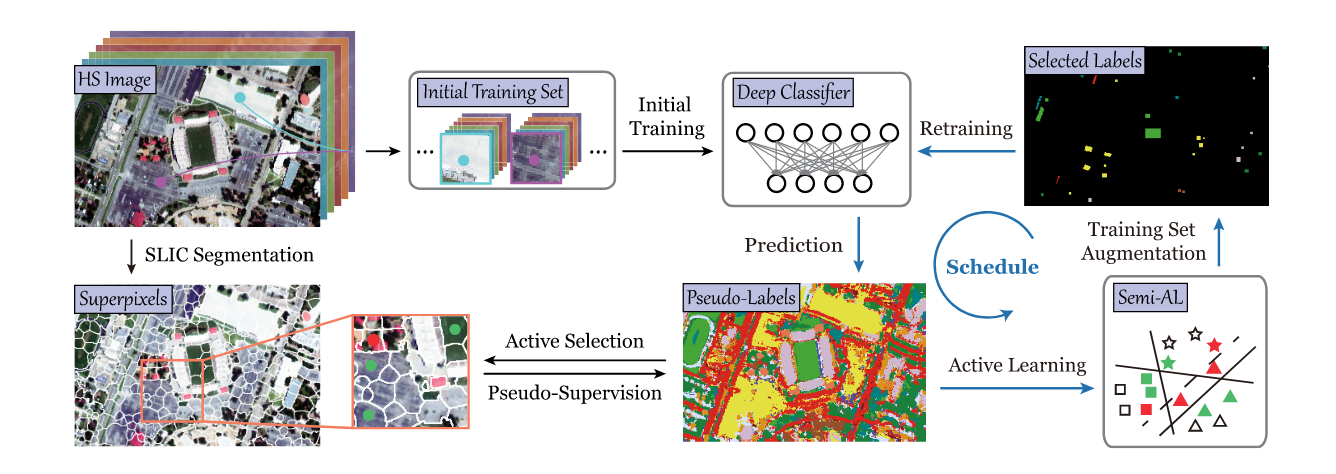

近年来,生成对抗网络(GAN)在高光谱图像(HSI)分类中取得了许多优异的成果,因为GAN可以有效解决HSI分类中训练样本有限的困境。然而,由于HSI数据的类不平衡问题,GAN总是将少数类样本与假标签相关联。为了解决这个问题,我们首先提出了一个包含Transformer的半监督生成对抗网络,称为HyperViTGAN。 所提出的HyperViTGAN设计有一个外部半监督分类器,以避免鉴别器执行分类和鉴别任务时的自相矛盾。具有跳跃连接的生成器和鉴别器用于通过对抗性学习生成HSI补丁。提出的HyperViTGAN捕获语义上下文和低级纹理以减少关键信息的丢失。此外,HyperViTGAN的泛化能力通过使用数据增强得到提升。在三个著名的 HSI 数据集 Houston 2013、Indian Pines 2010 和 Xuzhou 上的实验结果表明,与当前最先进的分类模型相比,所提出的模型实现了具有竞争力的HSI分类性能。

本文思路

尽管GAN与卷积神经网络(CNN)和RNN相结合在HSI分类中取得了有竞争力的结果,但在针对序列数据的方法仍然存在一些局限性。对于CNN来说,对于类别众多、光谱特征极其相似的HSI,很难很好地捕捉到序列属性,此外,CNN过于关注空间信息,扭曲了频谱上学习特征中的序列信息。以长短期记忆(LSTM)[34]和GRU[35]为代表的RNN是为顺序数据设计的。RNN能够像顺序网络一样从顺序数据中提取丰富的上下文语义。然而,RNN中的有效光谱信息存储在单个碎片神经元中,无法有效保留超长数据依赖性。此外,顺序网络结构使得难以有效地扩展和并行化LSTM和GRUs的计算。Transformer[36]的出现成功解决了CNN在捕获远程信息方面的不足。与 RNN 相比,Transformer允许并行计算,这减少了训练时间和由于长期依赖性导致的性能下降。计算两个位置之间的相关性所需的操作次数不会随着距离的增加而增加,其自注意力模块比 CNN 更容易捕获远程信息,使Transformer成为当今最前沿的模型之一。视觉 Transformer(ViT)[37]表明,Transformer不仅在自然语言处理(NLP)方面表现出色,而且在图像分类方面也取得了出色的性能。当前最先进的Transformer骨干网络在HSI分类领域也表现出了卓越的性能。

本文方法

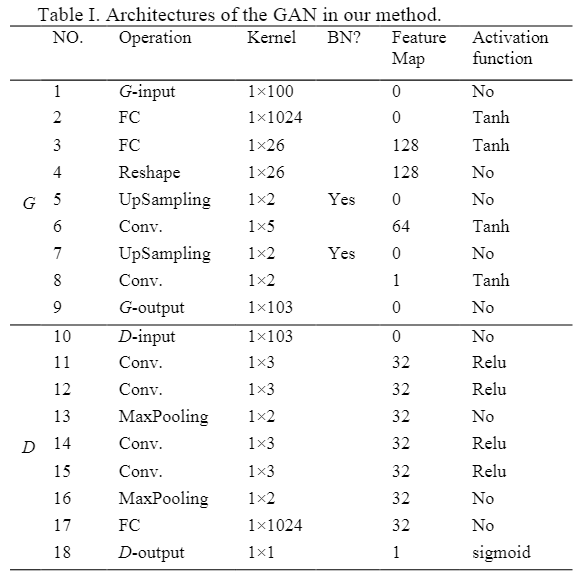

在本文中,我们首先针对HSI分类任务提出了一种基于半监督GAN的新型模型HyperViTGAN,并结合目前用于 HSI 分类的前沿且有前途的 Transformer。三个精心设计的基于高光谱ViT的级联元素——生成器、鉴别器和外部分类器——构成了 HyperViTGAN。设计一个具有单个判别输出的判别器和一个具有单个分类输出的外部分类器,可以有效消除当判别器执行分类和判别任务时的自相矛盾。此外,由于HyperViTGAN是专门为HSI设计的,它可以更好地保存频谱序列信息,以避免关键信息的丢失。同时,HyperViTGAN通过数据增强可以获得更好的泛化能力。 本文贡献如下:

- 本文首次提出了一个完全基于Transformer的HSI GAN——HyperViTGAN。HyperViTGAN为单一的判别任务和单一的分类任务分别设计了不同架构的判别器和外部半监督分类器。通过对抗学习和半监督学习,HyperViTGAN可以生成高光谱HSI patch,同时缓解HSI中类别不平衡的挑战。

- 设计了级联架构和跳跃连接,用于生成器、判别器和分类器,以提供类似于内存的信息,从而避免关键组件的丢失并提高分类性能。

其中

其中 其中

其中

其中

其中